前言

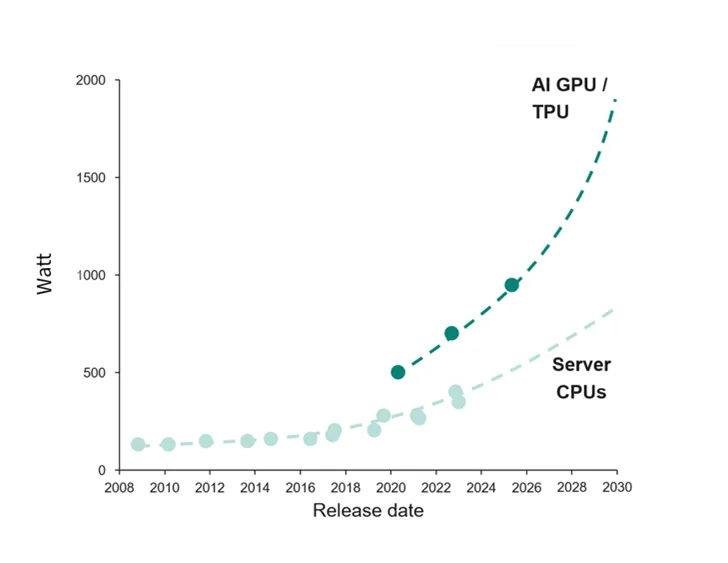

人工智能(AI)的迅猛发展推动了数据中心处理能力的显著增长。如图1所示,英飞凌预测单台GPU的功耗将呈指数级上升,预计到2030年将达到约2000W [1],而AI服务器机架的峰值功耗将突破惊人的300kW。这一趋势促使数据中心机架的AC和DC配电系统进行架构升级,重在减少从电网到核心设备的电力转换和配送过程中的功率损耗。

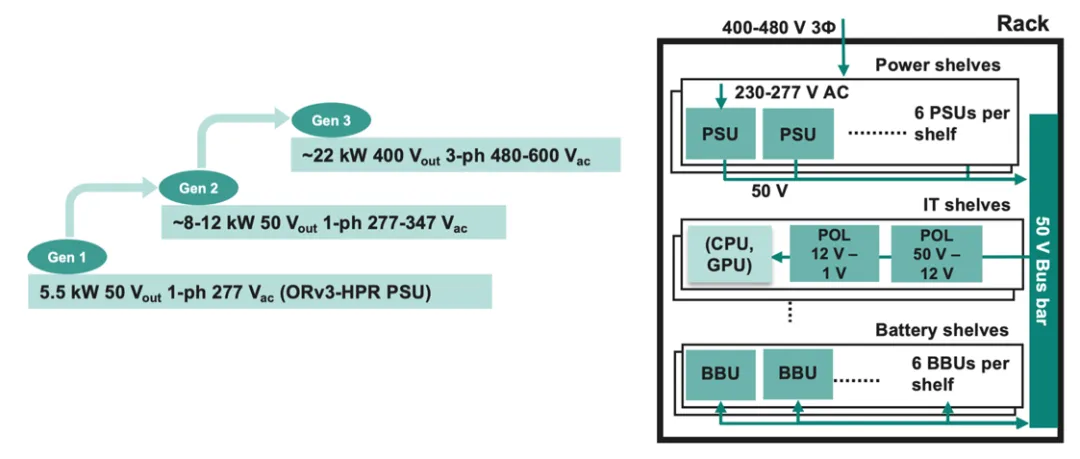

图2(右)展示了开放计算项目(OCP)机架供电架构的示例。每个电源架由三相输入供电,可容纳多台PSU;每台PSU由单相输入供电。机架将直流电压(例如,50V)输出到母线,母线则连接到IT和电池架。

AI的发展趋势要求对PSU功率进行革新,如图2(左)所示。接下来,我们将通过各代PSU的拓扑结构和器件技术建议示例,来逐步介绍这些PSU的演变。

图1 基于x86和Arm®架构的服务器CPU

与GPU和TPU的电力需求对比

图2 AI服务器PSU的功率演变(左);服务器机架架构示例(右)。

0755-82943322

产品咨询:2739375490